Автоматизируйте наполнение вашего сайта свежими новостями без ручного участия!

Этот мощный RSS-агрегатор для InstantCMS не просто собирает заголовки и анонсы, но и полностью парсит оригинальные статьи, загружая их на ваш сайт в полном объеме. Больше никаких «читать далее» с переходом на другой ресурс — ваши посетители получают весь текст сразу!

🔥 Ключевые возможности:

✔ Полный парсинг новостей – загрузка не только анонса, но и всего текста статьи с оригинального сайта.

✔ AI-обработка контента – уникальный функционал с использованием нейросетей для перефразирования, сокращения или адаптации текста под стиль вашего сайта.

✔ Автоматическая публикация – работает через Cron, добавляя новости по расписанию без вашего участия.

✔ Гибкие настройки – выбор источников, фильтрация по ключевым словам, настройка частоты обновлений.

✔ Поддержка изображений – загрузка и вставка картинок из оригинальных статей.

💡 Кому пригодится?

✅ Администраторам сайтов – больше не нужно вручную копировать новости, система сделает всё за вас.

✅ Контент-проектам – поддержание активной ленты публикаций без лишних затрат времени.

✅ Новостным порталам – автоматическое наполнение разделов актуальными материалами.

Сэкономьте время и усилия – позвольте плагину работать на вас!

Видео

Компонент RSS агрегатор с нейросетью для InstantCMS

[часть 2] Компонент RSS агрегатор с нейросетью для InstantCMS

Здравствуйте. Подскажите пожалуйста, в видео к компоненту показанно как гибко можно настроить автоматическую публикацию и разнос новостей по категориям. А возможно ли, также гибко, реализовать распределение материалов по полям ТК, в частности по полям местоположения. Хотя бы как то в полуавтомате.

Я имею ввиду, что большинство новостей имеют конкретную географическую привязку. Нет ли возможности реализовать привязку конкретного спарсенного материала, к значению компонента География?

Хотя бы на уровне предустановки По Умолчанию, вида Источник>>Регион.

Здравствуйте, у вас есть пример такой rss ленты? попробую сначала парсить координаты, потом подумает как их сохранить

Я не много не о том спросил, а может не так спросил. Нет, такой rss ленты, в которой есть поля с координатами и их можно было парсить в аналогичные поля на своем сайте, я незнаю.

Я про возможность привязки определенного регионального Источника новостей, к значению компонента География.

То есть, если беру новости с какого то ресурса Дагестана, например, то все новости с этого ресурса должны привязываться географически к Дагестану в компоненте География. И после публикации уже, эта привязка отображаеся на сайте, и доступна для фильтрации.

Покажу на примере своего сайта.

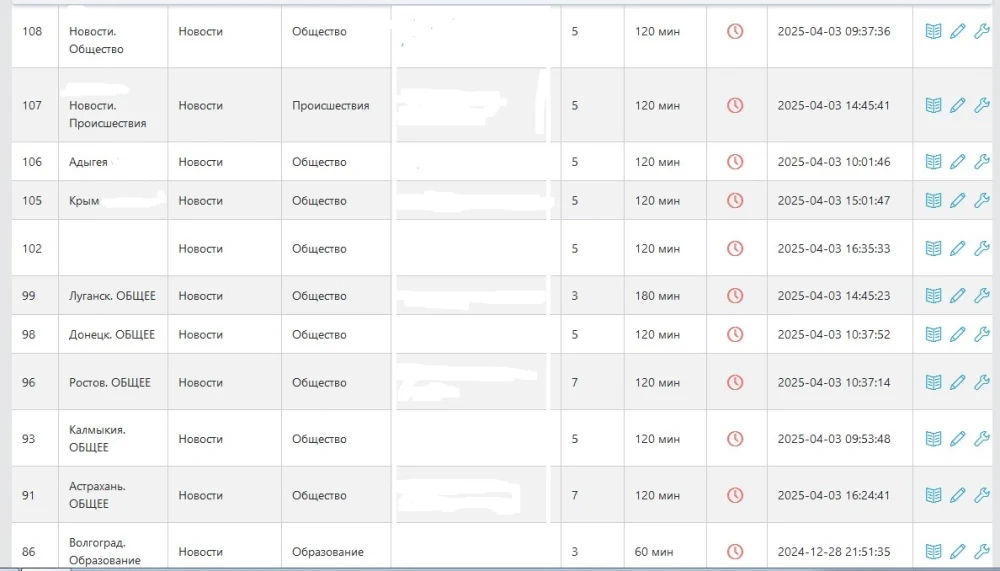

Источники новостей:

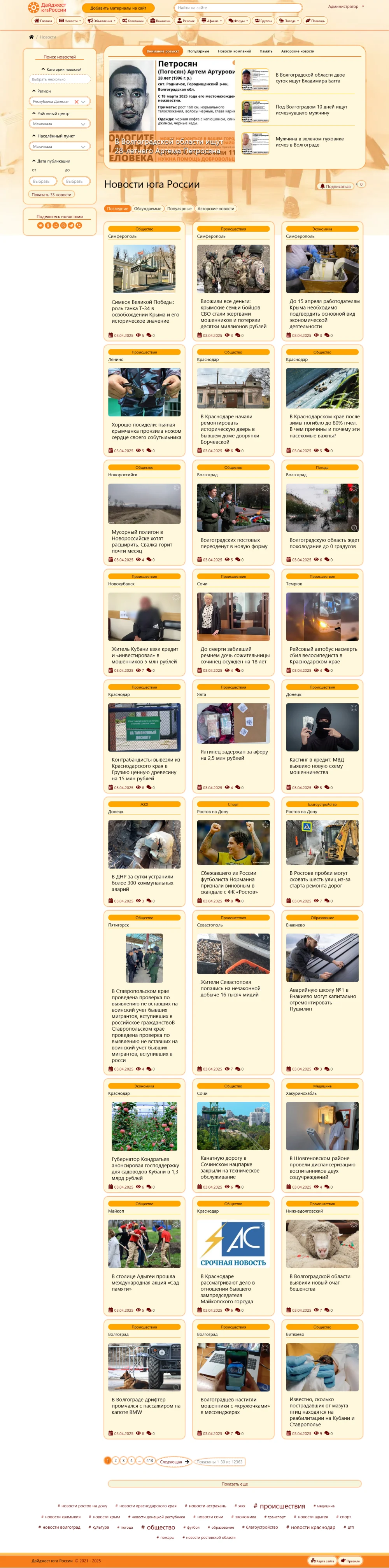

На сайте:

Привязка к компоненту География — это когда добавлено поле Местоположение и при добавление новости выбирается город?

В целом верно. Но наверное даже для ИИ, будет сложно автоматически распознать географическую принадлежность материала, и привязать новость к определенному городу.

Поэтому хотелось бы при настройке определенного источника, иметь возможность привязать все спарсенные материалы с данного источника к одной стране, региону, городу.

Понял, возможно попозже попробую реализовать смену типа контента (сейчас в news парситься) и выбор полей из этого ТК

Спасибо. В целом шикарная работа, особенно рерайт ИИ.

А от имени какого пользователя будут размещаться новости? Кто будет прописываться в поле автор?

Пользователь с ID=1

Попробую в следующих версиях сделать выбор автора или несколько авторов, при парсинге случайно выберется один

Дело в том, что когда парсинг и рерайт контента происходит в автоматическом режиме, очень логично подключить функцию модерации. Потому как процесс наполнения надо контролировать. Соответственно, необходимо всех возможных авторов материалов поместить в отдельную группу, которой будет запрещена публикация без модерации.

То есть в идеале должна быть опция, которая определяет группу пользователей, а компонент уже например рандомно выберет автора из этой группы.

Слишком муторно в плане реализации. Список id пользователей, кто может публиковать — всё.

Ну или так.

Да, с таким компонентом прямая дорога в бан поисковых систем, нейросети робот уже давно научился распознавать, такие сайты быстро исчезают из поиска, да что там говорить, они даже и не появляются ))

Зависит от сайта. Есть 100500 сайтов, которые занимаются тем же самым. Если обеспечите трафик, хорошие поведенческие, репосты, закладки, юзабилити, будет счастье.

Я думаю, рерайт от нейросети и рерайт сделанный в ручном режиме не сильно отличаются. По крайней мере не настолько, чтобы робот смог их различить.

изучаю компонент с момента выхода, проверяю тексты на ИИ в специальных сервисах, обнаруживает от 0 до 40% ИИ, в целом не плохо

Можно хотя бы парочку примеров таких сайтов, что исчезли с поиска. Проводил эксперимент с ИИ, уникальность рерайта от 70% и выше, читаемость статьи лучше чем оригинал, когда его хорошо попросить, ИИ выдает сео заголовок, описание, мета теги и про H1 не забывает. Не для рекламы.

Вы немного не правы, не яндекс не гугл ничего не имеют против ИИ генерации текста, есть просто определенные набор критериев по которым данные тексты считаются мусорными и вот если текст попал под эти правила, тогда они и вылетают из поисковой выдачи. На текущий момент все зависит от качества заданного промта и модели ИИ которая пишет текст, я сейчас работаю с большими моделями тот же DS R1 и аналогичные (с GPT 4 пока жаба душит 200$ отдавать за 1М токенов) и все тексты которые генерирую проходят тесты по определению творчества ИИ. Скажу более рассказ на 50к символов написанный на DS R1 и после 10 итерации улучшении, прошел модерацию на. конкурсе Литреса (дальше не стал его продвигать так как не считаю что это честно), но это показатель того что пока нет 100% детекторов на ИИ тексты (все зависит от промтов и того кто их пишет)

Поэтому данному компоненту есть место быть а вот использовать его или нет, это выбор каждого. Парвизу респект что он пишет новые разработки на инстант.

более того детекторы ИИ на один текст дают 40%, на другие 0%

Google сам использует AI при запросах в поиске. Эт чтож он работает по принципу «Инспектор Гаи» — «Мне можно, а ей Нельзя!»?

Конечно, гугл это Америка, а как всем известно именно по такому принципу они действуют, мне можно а всем нельзя. Возможно в скором времени все поменяется, хотелось бы верить)

Логично, так оно и есть, даже не поспоришь...

Вы в интернете почитайте, как поисковые роботы борятся с текстами ИИ

А чем этот плагин связан с посещаемостью? За 5 дней поиск только думать начнет индексировать ли или нет.

переходы на статьи опубликованные по ключам идут из поиска

Посмотрите на ситуацию, немного под другим углом. Хорошо, что пока ещё с этим, как то пытаются бороться, а значит в цене труд по созданию контента и качественных сайтов.

А все генераторы контента, как и раньше нужны для определенных целей и задач.

Кого то устраивает, а кого то нет… А кому то просто интересно, что получится).

Обновил компонент.

Что нового?